Un cluster de 132 noeuds pour modéliser l'après Big Bang

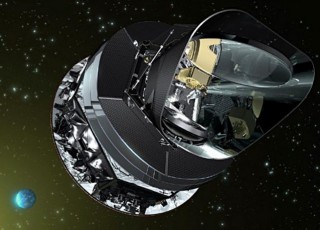

L'Institut d'Astrophysique de Paris (IAP) s'est doté d'un tout nouveau centre de calcul pour le projet Planck. Le satellite, qui a pris le nom du célèbre mathématicien, a pour vocation d'observer la lumière émise par l'univers tel qu'il était il y a plus de 13 milliards d'années, soit 380 000 ans après sa naissance. C'est la masse de données issue de ces observations (500 milliards de données brutes) qui devra être stockée et traitée par le biais des serveurs de l'IAP.

Le satellite Planck

HP, SGI et Sun ont répondu à l'appel d'offre, mais c'est IBM et son partenaire Serviware qui l'ont emporté. Si en termes techniques, les configurations se sont révélées assez proches les unes des autres, l'IAP, qui pilote pour le projet pour le compte de l'Agence spatiale européenne, a opté pour la prestation de service de Big Blue.

Sur des pièces vitales comme le commutateur Voltaire (qui assure l'interconnexion des noeuds du cluster), Serviware s'engage à résoudre le problème dans la journée. Sur des éléments moins cruciaux, il intervient au pire le lendemain (J+1). Il faut dire que la moindre panne sur la machine revient à gâcher le temps de fonctionnement d'un satellite dernier cri...

Les chercheurs voulaient un système économe, intégré et avec un système de fichiers fiable

Pour la troisième mouture de leur centre de calcul, les chercheurs ont listé trois exigences principales. Pour commencer, il fallait un système clé en main sur lequel les chercheurs n'auraient pas à intervenir avec le niveau de service idoine. Ensuite, la configuration choisie devait entrer dans une enveloppe thermique et énergétique finie, puisque la salle machine de l'Institut n'est en aucun cas extensible. Selon Philippe Parnaudeau, le système IBM installé devrait dépenser 50 kW à plein régime sachant qu'il fonctionnera plutôt entre 60 et 70% de ses capacités.

Enfin, dernière exigence, le système de fichiers devait être capable de gérer les masses de données issues du satellite de la façon la plus fiable possible. Le précédent calculateur s'appuyait sur le système Open Source Lustre. Mais Philippe Parnaudeau, chargé du cahier des charges et de l'infrastructure, précise que ce dernier « n'était pas assez mature lorsque [nous] l'avons testé ». Pour ces raisons, l'institut lui a donc préféré GPFS, le système de fichiers parallèle d'IBM.

Un cluster de 132 noeuds, avec 128 To de stockage rapide

Le système est un cluster iDataplex de 132 noeuds à base de quadri-coeurs Xeon E5472 à 3 GHz d'Intel (12Gflops par coeur, un cache de niveau 2 de 12 Mo, moins de 80W par processeur). Cette offre d'IBM, qui promet une puissance de plus de 12 Tflops, est destinée en particulier à réduire la consommation électrique et la dissipation de chaleur. C'est un commutateur Infiniband qui assure à la fois le passage de messages dans le cluster (MPI) et les échanges de données. Il assure une bande passante de 11,52 Tbps avec une latence de 420 ns. Le système de stockage rapide DCS 9900 d'IBM compte 160 disques pour une capacité utile de 128 To. Une configuration de stockage lente NFS lui ajoute 220 To.

Le satellite Planck

HP, SGI et Sun ont répondu à l'appel d'offre, mais c'est IBM et son partenaire Serviware qui l'ont emporté. Si en termes techniques, les configurations se sont révélées assez proches les unes des autres, l'IAP, qui pilote pour le projet pour le compte de l'Agence spatiale européenne, a opté pour la prestation de service de Big Blue.

Sur des pièces vitales comme le commutateur Voltaire (qui assure l'interconnexion des noeuds du cluster), Serviware s'engage à résoudre le problème dans la journée. Sur des éléments moins cruciaux, il intervient au pire le lendemain (J+1). Il faut dire que la moindre panne sur la machine revient à gâcher le temps de fonctionnement d'un satellite dernier cri...

Les chercheurs voulaient un système économe, intégré et avec un système de fichiers fiable

Pour la troisième mouture de leur centre de calcul, les chercheurs ont listé trois exigences principales. Pour commencer, il fallait un système clé en main sur lequel les chercheurs n'auraient pas à intervenir avec le niveau de service idoine. Ensuite, la configuration choisie devait entrer dans une enveloppe thermique et énergétique finie, puisque la salle machine de l'Institut n'est en aucun cas extensible. Selon Philippe Parnaudeau, le système IBM installé devrait dépenser 50 kW à plein régime sachant qu'il fonctionnera plutôt entre 60 et 70% de ses capacités.

Enfin, dernière exigence, le système de fichiers devait être capable de gérer les masses de données issues du satellite de la façon la plus fiable possible. Le précédent calculateur s'appuyait sur le système Open Source Lustre. Mais Philippe Parnaudeau, chargé du cahier des charges et de l'infrastructure, précise que ce dernier « n'était pas assez mature lorsque [nous] l'avons testé ». Pour ces raisons, l'institut lui a donc préféré GPFS, le système de fichiers parallèle d'IBM.

Un cluster de 132 noeuds, avec 128 To de stockage rapide

Le système est un cluster iDataplex de 132 noeuds à base de quadri-coeurs Xeon E5472 à 3 GHz d'Intel (12Gflops par coeur, un cache de niveau 2 de 12 Mo, moins de 80W par processeur). Cette offre d'IBM, qui promet une puissance de plus de 12 Tflops, est destinée en particulier à réduire la consommation électrique et la dissipation de chaleur. C'est un commutateur Infiniband qui assure à la fois le passage de messages dans le cluster (MPI) et les échanges de données. Il assure une bande passante de 11,52 Tbps avec une latence de 420 ns. Le système de stockage rapide DCS 9900 d'IBM compte 160 disques pour une capacité utile de 128 To. Une configuration de stockage lente NFS lui ajoute 220 To.