Pour rivaliser avec Nvidia, AMD mise sur la mémoire avec sa puce Instinct MI300X

Selon la CEO d'AMD, Lisa Su, une seule puce Instinct MI300X est capable de faire le travail de plusieurs GPU,grâce à sa grande quantité de mémoire partagée.

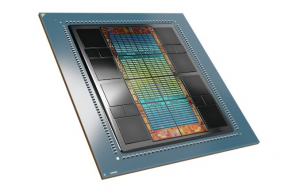

Avec sa puce Instinct, lequel serait capable de faire le travail de plusieurs GPU, AMD défie Nvidia sur le terrain de l'intelligence artificielle. Mardi dernier, lors d'un événement organisé à San Francisco où elle a présenté la puce, la CEO d'AMD a déclaré que l'Instinct MI300X était « la chose la plus complexe jamais construite par AMD ». De la taille d'un dessous de verre, l'Instinct MI300X comporte 146 milliards de transistors, une mémoire HBM3 à large bande passante partagée par le CPU et le GPU pouvant atteindre 192 Go, pour un total de 13 chiplets. La puce dispose également d'une bande passante mémoire de 5,2 TB/s, c'est-à-dire qu'elle est 60 % plus rapide que la H100 de Nvidia. L'Instinct MI300X se compose de plusieurs coeurs CPU Zen et d'un GPU CDNA 3.

Mais l'énorme quantité de mémoire est le véritable argument de vente, selon Mme Su. « Aujourd'hui, on constate souvent dans l'industrie que la taille des modèles est de plus en plus grande et que l'on a besoin de plusieurs GPU pour faire fonctionner les derniers grands modèles de langage », a-t-elle déclaré. « Avec la puce MI300X, on peut réduire le nombre de GPU, et comme la taille des modèles continue de croître, ce critère deviendra encore plus important. Il offre plus de mémoire, plus de bande passante de mémoire et moins de GPU sont nécessaires ». Selon AMD, du fait de son design, la puce MI300X est 8 fois plus puissante que la puce MI250X qui équipe le Frontier (le superordinateur le plus rapide au monde) et 5 fois plus économe en énergie. Elle équipera le système El Capitan de plus de deux exaFLOP qui sera construit l'année prochaine au Lawrence Livermore National Labs.

Accompagné l'Open Compute

Lors de ce même évènement, Mme Su a également dévoilé la plateforme Instinct. Ce design de référence de serveur basé sur les spécifications de l'Open Compute Project utilise 8 GPU MI300X pour les charges de travail d'entraînement et d'inférence de l'IA générative. Cela signifie que les entreprises et les hyperscalers peuvent utiliser la plateforme Instinct pour intégrer des GPU MI300X dans des racks de serveurs OCP existants. « Nous accélérons réellement le temps de mise sur le marché des clients et réduisons les coûts de développement globaux, tout en facilitant le déploiement du MI300X dans leur rampe d'IA existante et leur construction de serveurs », a déclaré la CEO d'AMD.

Un CPU taillé pour le cloud

AMD a également présenté son processeur EPYC 97X4 de quatrième génération, nom de code Bergamo, spécialement conçu pour les environnements cloud, du fait de ses nombreux coeurs pour l'exécution des machines virtuelles. Bergamo est doté de 128 coeurs avec hyperthreading, de sorte qu'un système à deux sockets peut disposer d'un maximum de 256 CPU virtuels. Mme Su a expliqué que les charges de travail natives du cloud étaient « nées dans le cloud ». Elles sont conçues pour tirer pleinement parti des derniers frameworks du cloud et fonctionnent essentiellement comme des microservices. Le design de ces processeurs est différent de celui de l'IT traditionnelle : les processeurs Bergamo sont plus petits et très orientés vers le débit, d'où la conception à plusieurs coeurs. « Bergamo exploite toute l'infrastructure de plateforme déjà développée pour Genoa. Il prend en charge la même mémoire de nouvelle génération et les mêmes capacités d'E/S. Mais il permet, grâce à ce point de conception, d'obtenir des performances supérieures à celles des processeurs traditionnels. Surtout, il permet, avec ce point de conception, de passer à 128 coeurs par socket pour des performances de pointe et une efficacité énergétique dans le cloud », a aussi expliqué Mme Su. Des échantillons du MI300X et du Bergamo seront disponibles au cours du troisième trimestre de cette année.